آزمایشهای گسترده ایجنت جدید ChatGPT نتایجی دور از انتظار را رقم زد. آیا این ابزار قدرتمند واقعا قابل اعتماد است یا با توهمات خود ما را به اشتباه میاندازد؟

بررسیهای جامع و دقیق روی ابزار جدید OpenAI نشان میدهد که ایجنت جدید ChatGPT علیرغم تواناییهای بالقوه، هنوز فاصله زیادی تا تبدیل شدن به یک دستیار قابل اعتماد دارد و در بسیاری از موارد، حقایق جایگزین و اطلاعات نادرست تولید میکند. این ابزار که قرار است ترکیبی از تحقیق عمیق و اجرای دستورات در محیط کامپیوتر باشد، در عمل با چالشهای جدی روبرو است.

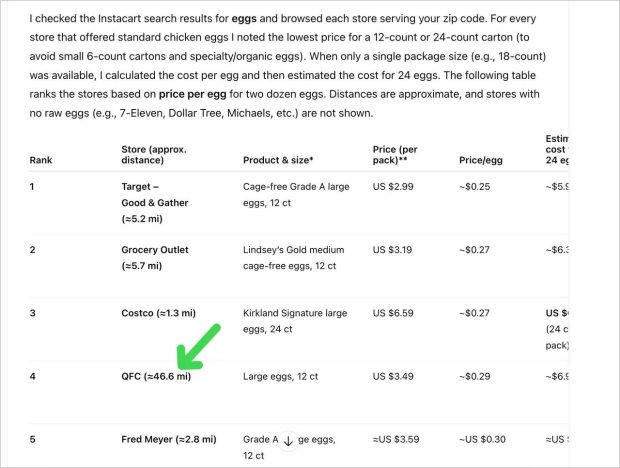

دیوید گیرویتز، نویسنده ارشد وبسایت ZDNET، در یک گزارش مفصل، تجربه خود از کار با این ایجنت را به اشتراک گذاشته است. او برای این آزمایش، اشتراک حرفهای ۲۰۰ دلاری OpenAI را تهیه کرد تا بتواند قابلیتهای این مدل را به چالش بکشد. نتایج کلی این آزمایشها نشان میدهد که اگرچه ChatGPT درک درستی از صورت مسئله دارد، اما در اکثر موارد خروجیهای آن غیرقابل استفاده و مملو از خطا هستند.

عملکرد کلی ایجنت جدید ChatGPT چگونه بود؟

در نگاه اول، این ابزار بسیار قدرتمند به نظر میرسد. ایجنت جدید ChatGPT میتواند پنجرهها را باز کند، روی عناصر مختلف کلیک کند و وظایف مشخصی را انجام دهد. با این حال، آزمایشهای متعدد نشان داد که این ابزار محدودیتهای قابل توجهی دارد. برای مثال، در پروژههای بزرگ و تحلیل دادههای حجیم با مشکل مواجه میشود و حتی نمیتواند صفحات وب طولانی را به درستی اسکرول کند.

یکی از مشکلات اصلی، توهم یا Hallucination هوش مصنوعی است. این مدل گاهی اطلاعاتی را با اطمینان کامل ارائه میدهد که هیچ پایه و اساس واقعی ندارند. این موضوع به ویژه زمانی نگرانکننده میشود که کاربران بخواهند از خروجیهای آن برای مقاصد حرفهای استفاده کنند. نویسنده گزارش تاکید میکند که بدون بررسی و اعتبارسنجی دقیق، اعتماد به دادههای این ایجنت میتواند بسیار پرخطر باشد.

بیشتر بخوانید:

دستیار مجازی جدید OpenAI از راه رسید؛ ChatGPT Agent به جای شما کار میکند

رشد انفجاری کاربران ChatGPT؛ از 300 میلیون به 500 میلیون نفر در چند ماه

نتایج حیرتانگیز هدایت فضاپیما توسط ChatGPT؛ هوش مصنوعی جایگزین فضانوردان میشود!

شکست در وظایف ساده و موفقیت در یک چالش پیچیده

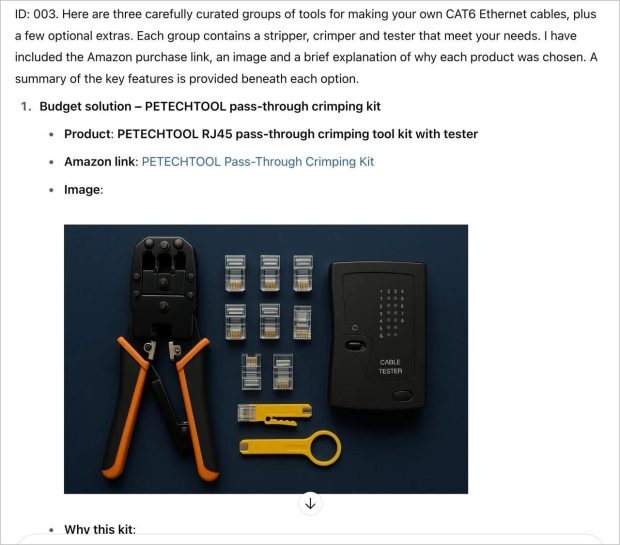

گیرویتز هشت آزمون مختلف را برای ارزیابی عملکرد ایجنت طراحی کرد. در یکی از این آزمونها، از ایجنت خواسته شد تا ابزارهای لازم برای ساخت کابل شبکه را از وبسایت آمازون پیدا کند. اگرچه مدل توانست یک کیت اقتصادی و مناسب را پیشنهاد دهد، اما لینکهای ارائه شده برای محصولات گرانتر همگی نامعتبر و ساختگی بودند. این نشان میدهد که ایجنت توانایی اعتبارسنجی منابع خود را ندارد.

در آزمون دیگری، از ایجنت خواسته شد تا یک اسلاید پاورپوینت را بر اساس دادههای جدید ویرایش کند. مدل توانست داده جدید را به نمودار اضافه کند، اما کیفیت گرافیکی، فونتها و چینش عناصر کاملا به هم ریخته بود. این نتایج نشان میدهد که ابزار هنوز برای تولید محتوای بصری حرفهای آماده نیست.

با این حال، همه چیز ناامیدکننده نبود. در آخرین آزمون، از ایجنت خواسته شد تا قوانین ساختمانی مربوط به نصب یک حصار را در یک منطقه مشخص تحلیل کند. در کمال شگفتی، ایجنت جدید ChatGPT در عرض تنها چهار دقیقه، یک تحلیل دقیق و صحیح همراه با نمودارهای کاربردی ارائه داد. این خروجی آنقدر باکیفیت بود که میتوانست مستقیما برای مراحل بعدی پروژه مورد استفاده قرار گیرد. این موفقیت نشاندهنده پتانسیل بالای این فناوری در صورت توسعه و بهبود است.

آیا میتوان به این دستیار هوشمند اعتماد کرد؟

پاسخ کوتاه، خیر است. حداقل نه در حال حاضر. عملکرد این ابزار بیشتر شبیه یک دستیار بیتجربه و غیرقابل پیشبینی است که گاهی درخشان عمل میکند و گاهی نتایج کاملا اشتباه تحویل میدهد. این فناوری بدون شک آینده هیجانانگیزی را نوید میدهد، اما در وضعیت فعلی، نمیتواند جایگزین یک نیروی انسانی متخصص و قابل اعتماد شود.

کاربران باید با احتیاط فراوان از این ابزار استفاده کنند و هرگز خروجیهای آن را بدون بررسی مجدد، مبنای تصمیمگیریهای مهم خود قرار ندهند. به نظر میرسد باید منتظر بمانیم تا ببینیم OpenAI چگونه بر این چالشها غلبه خواهد کرد و آیا نسلهای بعدی این ایجنتها میتوانند به سطح قابل قبولی از اطمینان و دقت برسند یا خیر.

گجت نیوز آخرین اخبار تکنولوژی، علم و خودرو

گجت نیوز آخرین اخبار تکنولوژی، علم و خودرو