شیائومی با معرفی Xiaomi-Robotics-0، اولین مدل رباتیک بزرگمقیاس خود، گامی بلند در هوش مصنوعی و رباتیک برداشت. این مدل متنباز حرکات را میفهمد و اجرا میکند.

پلتفرم پیشرفته Xiaomi-Robotics-0، یک مدل بینایی-زبان-عمل (VLA) با ۴٫۷ میلیارد پارامتر است که برای دستیابی به هوش فیزیکی در رباتها طراحی شده. مدل رباتیک متن-باز شیائومی رکوردهای جدیدی را در شبیهسازی و دنیای واقعی به ثبت رسانده است.

اجزای کلیدی معماری شیائومی Robotics-0

شیائومی Robotics-0 شامل دو جزء اصلی است. اولی یک مدل زبان بصری (VLM) است که بهعنوان مغز عمل کرده و دستورات انسانی و روابط فضایی را از ورودیهای بصری تفسیر میکند. این VLM توانایی تشخیص اشیا و استدلال منطقی دارد. دومین جزء، متخصص عمل (Action Expert) نام دارد که بر پایه یک Diffusion Transformer (DiT) چند لایه ساخته شده و دنبالهای از حرکات (Action Chunk) را تولید میکند تا حرکات ربات دقیق و روان باشند. این مدل رباتیک متن-باز بهگونهای آموزش دیده که قابلیتهای درکی خود را هنگام یادگیری اعمال فیزیکی حفظ کند.

- سگهای رباتیک امنیت جام جهانی 2026 را تضمین میکنند

- رونمایی از اولین ربات هوش مصنوعی بیومیمتیک جهان با پوست گرم و احساسات

- کارخانه مخوف شیائومی؛ ساخت ۱۰ میلیون موبایل در تاریکی مطلق!

- رقص حیرتانگیز رباتهای انساننما؛ تکنولوژی که هوش از سرتان میبرد

بهینهسازی و عملکرد

فرآیند آموزش شامل مراحلی است که VLM را به پیشبینی توزیعهای احتمالی عمل وادار میکند، سپس DiT برای تولید توالیهای دقیق عمل آموزش میبیند. شیائومی همچنین برای غلبه بر تاخیر در استنتاج، از استنتاج ناهمگام استفاده کرده تا حرکات ربات پیوسته باقی بمانند. تکنیک «پیشوند عمل پاک» پایداری را افزایش داده و ماسک توجه Λ-شکل، پاسخگویی ربات را به تغییرات محیطی بهبود میبخشد.

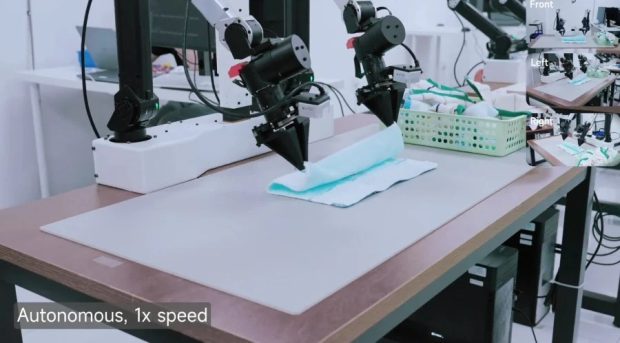

در تستهای بنچمارک، شیائومی Robotics-0 در شبیهسازیهای LIBERO، CALVIN و SimplerEnv به نتایج پیشگامانهای دست یافته و از حدود ۳۰ مدل دیگر عملکرد بهتری از خود نشان داده است. در آزمایشهای دنیای واقعی نیز، روی یک ربات دو-بازویی، هماهنگی قوی دست و چشم و توانایی مدیریت اشیاء صلب و منعطف را در کارهای پیچیدهای مانند تا کردن حوله به نمایش گذاشته است. این مدل، بر خلاف سیستمهای VLA پیشین، تواناییهای بصری و زبانی خود را به خوبی حفظ میکند.

گجت نیوز آخرین اخبار تکنولوژی، علم و خودرو

گجت نیوز آخرین اخبار تکنولوژی، علم و خودرو