زمانی که شما به دنبال مباحث روزمره، جستجوگر گوگل را باز میکنید، معمولا انتظار ندارید که با موضوعات نژادپرستانه روبرو شوید. اما اگر شما یک زن باشید و یک مدل مو را سرچ کنید، نتیجه کمی شما را شوکه خواهد کرد. به نظر میرسد نژادپرستی در ربات ها در حال نزدیک شدن به واقعیت است.

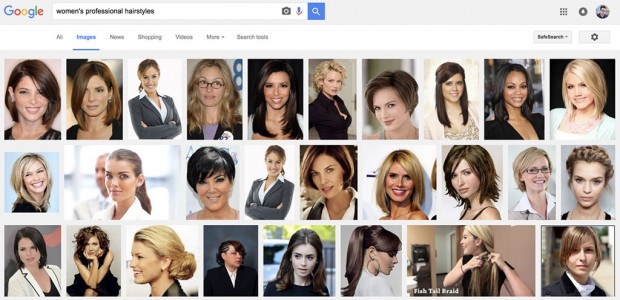

با جستجوی عبارت women’s professional hairstyles (مدل موی زنانه حرفهای) در قسمت تصاویر جستجوگر گوگل، با نتیجه زیر مواجه میشوید:

در اینجا شما مدلهای موی حرفهای که معمولا توسط متخصصین آرایش مو درست شدهاند را میبینید. این طبیعت گوگل است. هوش مصنوعی گوگل این نتایج را بر اساس پیشزمینههایی که از شما دارد در اختیارتان قرار داده است. به طور کلی، این یعنی اینکه شما قبلا با ارائهی این نتایج از سوی گوگل، لبخند رضایتی به لب داشتهاید.

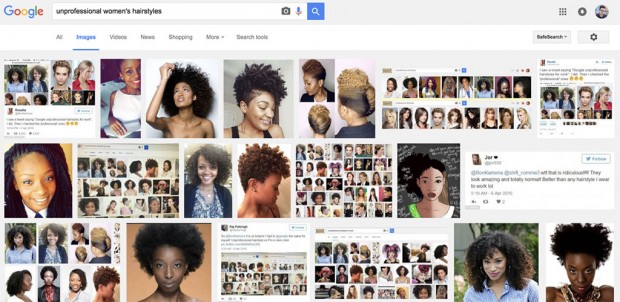

حال ببینیم اگر عبارت unprofessional women’s hairstyles (مدل موی زنانه غیرحرفهای) را جستجو کنیم چه میشود. نتایج چیزی شبیه به تصویر زیر است:

نتیجهی جستجو، چند زن سیاهپوست را نشان میدهد که موهای فر و وزوزی دارند، اما با این حال، همگی خوب و طبیعی به نظر میرسند. نظر شخصی من این است که من هیچ چیز غیرحرفهای در این تصاویر نمیبینم.

این تصاویر، در نتیجه جستجو نشان داده شدهاند فقط به این دلیل که قبلا توسط خیلی از مردم مورد پذیرش قرار گرفتهاند. بسیاری از کارفرمایان، همکاران و دیگر کسانی که این اشخاص با آنها کار کردهاند، این مدل مو را مناسب محل کار نمیدانند. این مسالهای جدید نیست و بارها توسط وبسایتهای مد و فشن اقرار شده و مهر تاییدی است بر این نظریه که این ما هستیم که نژادپرستی در ربات ها را شکل داده و گسترده کردیم.

در واقع، هوش مصنوعی نظرات ما را در خصوص موضوعات مختلف جمعآوری کرده و از آنها درس میآموزد. در حالت کلی، هوش مصنوعی بر تعصبات ما سوار شده و آنها را بیشتر از قبل در زندگی روزمرهی خودمان نمایان میسازد.

نمونههایی از وجود نژادپرستی در ربات ها

- اخیرا در حالی که دونالد ترامپ (Donald Trump) نامزد حزب جمهوریخواه ایالات متحده، سخنان نژادپرستانه، جنسیتگرایانه و بیگانهستیزی جهت – بنا به ادعای او – ساختن آمریکایی بزرگ میزد، این جملهها مورد استفاده روباتهای توییتر قرار میگرفت تا دیدگاههایش را منتشر کنند.

- چند وقت پیش روبات نوجوان مایکروسافت تای (Tay) معصومیت خود را فراموش کرده و چندین ساعت به انتشار سخنان و دیدگاههای نژادپرستانهی هیتلر پرداخت.

- یک ربات زیباییشناس به این نتیجه رسید که رنگینپوستان به زیبایی سفیدپوستان نیستند.

این تازه شروع کار است. هوش مصنوعی بهکار رفته در نمونههای بالا، به نظر کاملا بیضرر هستند در حالی که وجود نژادپرستی در ربات ها روز به روز در حال پیشرفت است. بدتر از همه اینکه، الگوهایی که پلیسهای ما (ایالات متحده) در حال گسترش و استفاده از آنها هستند، دقیقا عملکردی مانند عملکرد همین ربات ها دارد. به زبان سادهتر، در آیندهای نزدیک، حضور یا عدم حضور پلیس در یک محله، بر اساس اطلاعاتی خواهد بود که ما با عنوان تعصب و نژادپرستی آنها را میشناسیم.

انسان هنوز ظرفیت بالایی که هوش مصنوعی میتواند داشته باشد را درک نکرده و ممکن است دهها سال طول بکشد تا به این نکته پی ببرد که مقدار زیادی از زندگیاش توسط الگوریتمهای هوش مصنوعی در حال اداره هستند.

گجت نیوز آخرین اخبار تکنولوژی، علم و خودرو

گجت نیوز آخرین اخبار تکنولوژی، علم و خودرو